自动驾驶、人脸识别、基因编辑、脑机接口......毫无疑问,这是一个科技高速发展的时代,高速发展的科学技术带动了工业、服务业等多个领域的快速转型,也使得技术应用的界限愈加模糊,人脸识别带来的银行财产纠纷、虚拟人的知识产权归属、数据采集涉及到的隐私权问题等等诸多争议也一并出现。

而这些争议就与伦理相关原则有关,如涉及到隐私保护的数据伦理,涉及到透明性问题的算法伦理,以及机器服务人类时涉及到的“保护人类还是听从命令”的道德抉择。可以说,只有更好地理解和规范科技伦理,才能使科技长久地发展下去,并真正为人类带来福祉。

【资料图】

【资料图】

9月7日,在2022中国互联网法治大会的分论坛“合规科技——科技伦理治理分论坛”上,来自中国信通院、中科院的学者,以及阿里、百度、科大讯飞等多名企业高管对上述问题进行了讨论。有专家表示,科技中的伦理问题并不等同于底线,也有专家认为,机器人和数字人绝对不能作为主体。

伦理不是底线,人工智能不应以人类为中心

“首先,伦理讲的肯定不是底线问题。”中国科学院大学自动化研究所研究员、人工智能伦理与治理研究中心主任曾毅这样表示。

他认为,人工智能的发展实际上就是伦理和治理的问题,伦理讨论会同时包括“应该做什么”和“不应该做什么”两个问题,而底线只会讲“不应该做什么”,但现在对于应该往哪个方向走的问题讲得太少,所以当有触碰底线的情况发生,就不得不去讲不应该做什么。

在曾毅看来,伦理和治理不是监管,要把伦理和治理变成服务,才能真正推动人工智能产品和产业的创新,帮助企业——特别是中小企业推动在伦理治理方面的发展,使人工智能能够“负责任且可持续”地发展。

并且,由于现在人工智能的概念已经泛化,出现了诸如大数据、虚拟现实、自动控制、脑机接口等多个“外延”应用,因此,曾毅认为应该特别规范这些外延的野蛮生长。

他举了一个隐私方面的例子,比如现在大众都耳熟能详的人脸识别技术在有些国家是被禁用的,但这并不意味着这样的国家就更负责任,因为除了众所皆知的“人脸识别”之外,还有步态识别、虹膜识别、声纹识别等手段,也能达到相同的目的。在这个过程中,最重要的是在使用中让用户对相关隐私问题真正知情,而非禁用之后再用其他方式去做替代。

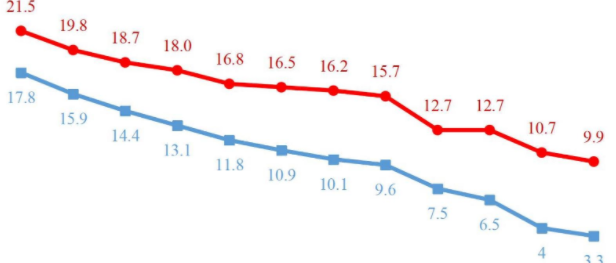

而且,曾毅及团队通过对1000万篇计算机科学及人工智能领域的英文文献进行数据分析,还发现人工智能在不同领域展现出了不同的可持续发展倾向,其中前三位分别为工业创新、优质教育和健康。

为何是这三个领域?“原因很简单,因为它们都赚钱。” 曾毅说。

他补充解释,像是性别平等、清洁能源、水资源等等问题是社会政府非常关注的,但在商业价值上却没那么强,因此科技也就并不关注它们。也正因如此,才应该倡导产学研在政府的引导下去赋能。

那么对于人工智能本身来说呢?曾毅的观点是:既不能让人工智能构建下的数字人、虚拟人成为主体,也不要完全以人类为中心,

“如果从哲学的观点来讲,人工智能是人工的僵尸,它能够做信息处理,但没有真正地理解,更没有自我的视角,也没有推己及人,本质上它是一个智能信息处理工具,你把什么样的规则灌输给它,它就会变成什么样。”曾毅表示。

至于为什么“不要完全以人类为中心”,曾毅认为在科技高速发展的现代社会,人类与不同生命个体有着高度的关联,所以应该是“以生态为中心”。

AI正在模仿法律意义上的“主体”

对于“人工智能应该以整个生态为研究中心”的看法,北京理工大学法学院副教授,智能科技风险法律防控工信部重点实验室执行主任陈姿含从法律角度提出了自己的看法。

“法学在解决问题的时候,首先要进行人和客观世界的划分,那么智能算法可能产生的伦理问题,就是由人工智能冲击了人与客观世界的边界之后带来的。”陈姿含说。

什么意思呢?像是性别、宗教信息等等数据,在法律中会将其视为个人敏感信息或公共数据,用其保证公平和争议,而智能算法不仅会辅助法律去规制对信息不必要的利用行为,还会在其间建立一种关联,同时挖掘更多的关联性信息作为替代。因此,这就有可能产生对既有的秩序、公平和正义的冲击。

在陈姿含看来,解决人工智能的伦理问题有两个非常重要的思考点:

首先是解决人工智能算法相关决策,建立具体法律的制度性保障。这本质上也是安全问题,也是科技探求最为重要的出发点,解决了安全需求,知道如何用法律对自己和事件进行保护,才能够探讨其他制度性构建。

其次是公共算法决策对制度的整体性冲击,尤其要思考人类的主体性危机。陈姿含表示,大众现在已经建立起对国家和法律的一种信任,但如果将决策依据调整为公共算法,谁是治理主体,算法又有没有可能导致不公,存不存在权力的外包等等新问题就会出现。

“主体性危机”是什么?陈姿含从两个方面解释:

首先人工智能或者算法模拟了人作为法律主题的物理性基础,比如像是AlphaGo这样的AI就模仿了人类的理性思维,拥有强大的计算能力。

其次算法复制了“法律主体”的拟制过程。法律上人的概念与生物学上的人是相互区别的,法律划定的个人的社会关系是指一个人能够控制的与个体相关的信息,比如身体、物理空间以及隐私,这些信息不仅可以在个体组成的社会网络中进行有效连接,还能够刺破公共区域,介入到私人领域中去而。但很多时候,人工智能恰好需要这些信息才能做到非常稳定的决策,那么这时,人的心智在某种程度上就被还原为了客观的物质。

现在,人工智能律师、人工智能警察等等都在进入人类的生活,作为一个法律学者,陈姿含认为,这都使得法律主体的一元论受到了挑战,因此这时就需要思考,算法、人工智能、数字人到底是服务于人类,还是在决定人类。

“事实上,法律上将人类划分社会契约的主体,并不是因为人类较之于以往的生物多么的优秀,而是在强调人都是理性的,纵然在现实生活中有千差万别,也应该受到平等的保护。但差异化定价、个性化歧视等算法则加剧了人类差别的挖掘。而对于我们人类来说,应当是以人作为出发点,并且以保障个体权利为最终归宿。”陈姿含说。

(文章来源:南方都市报)